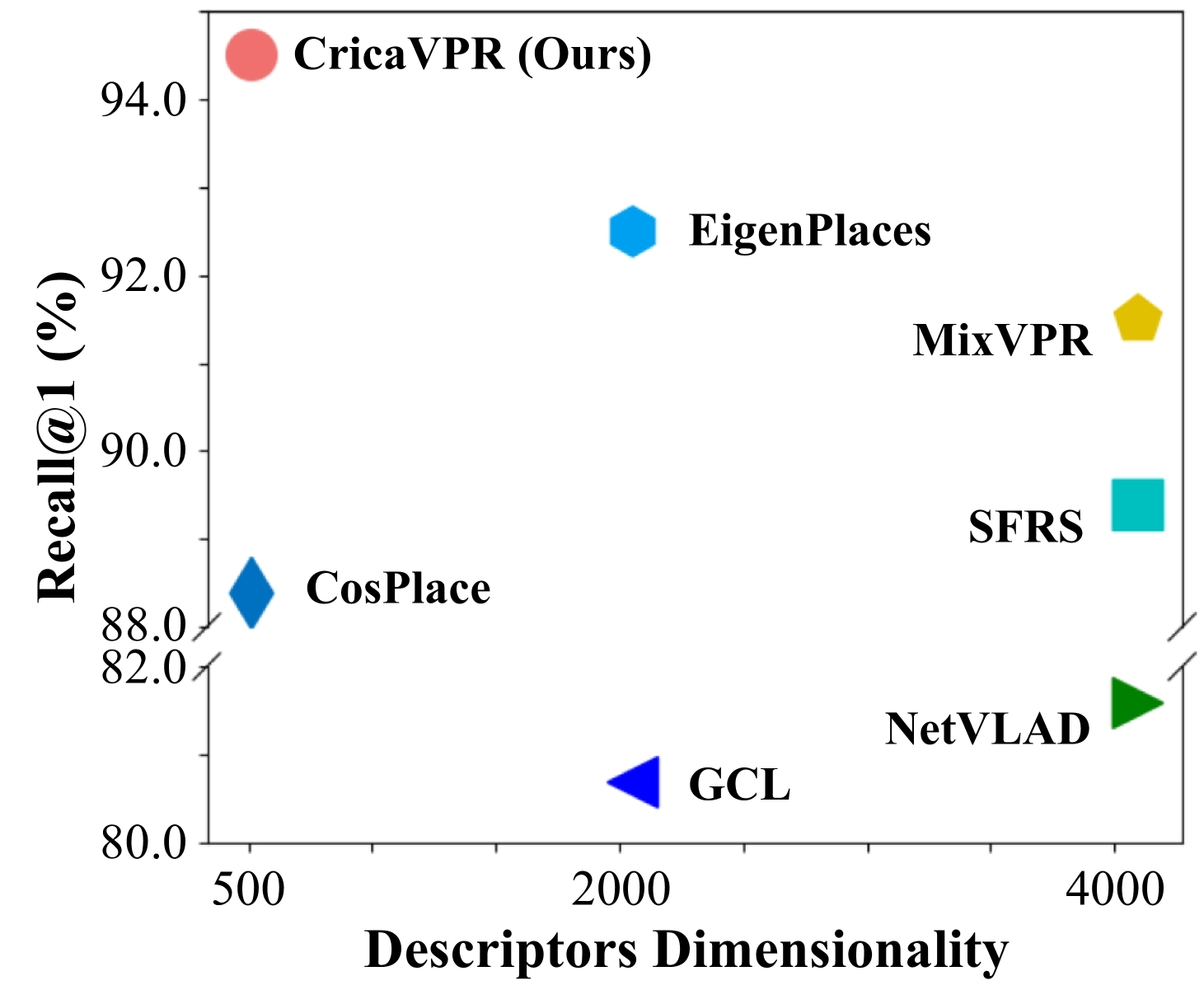

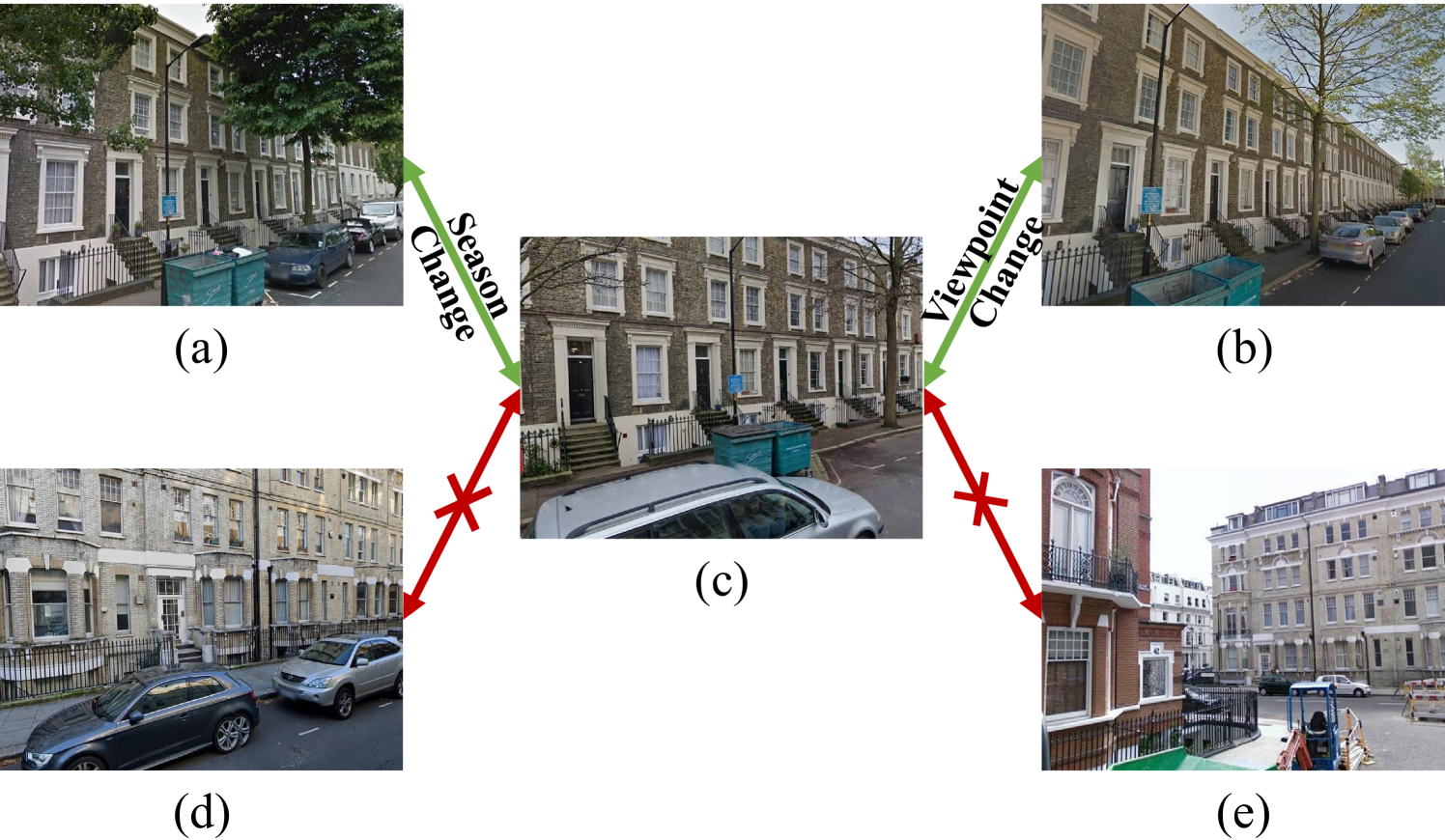

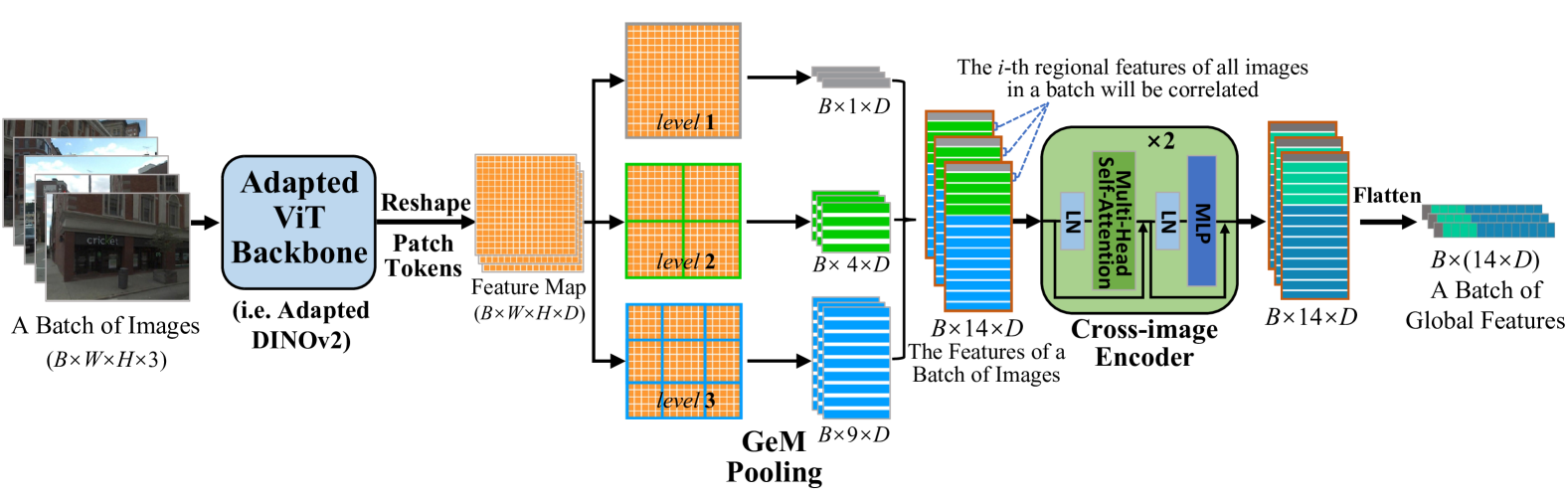

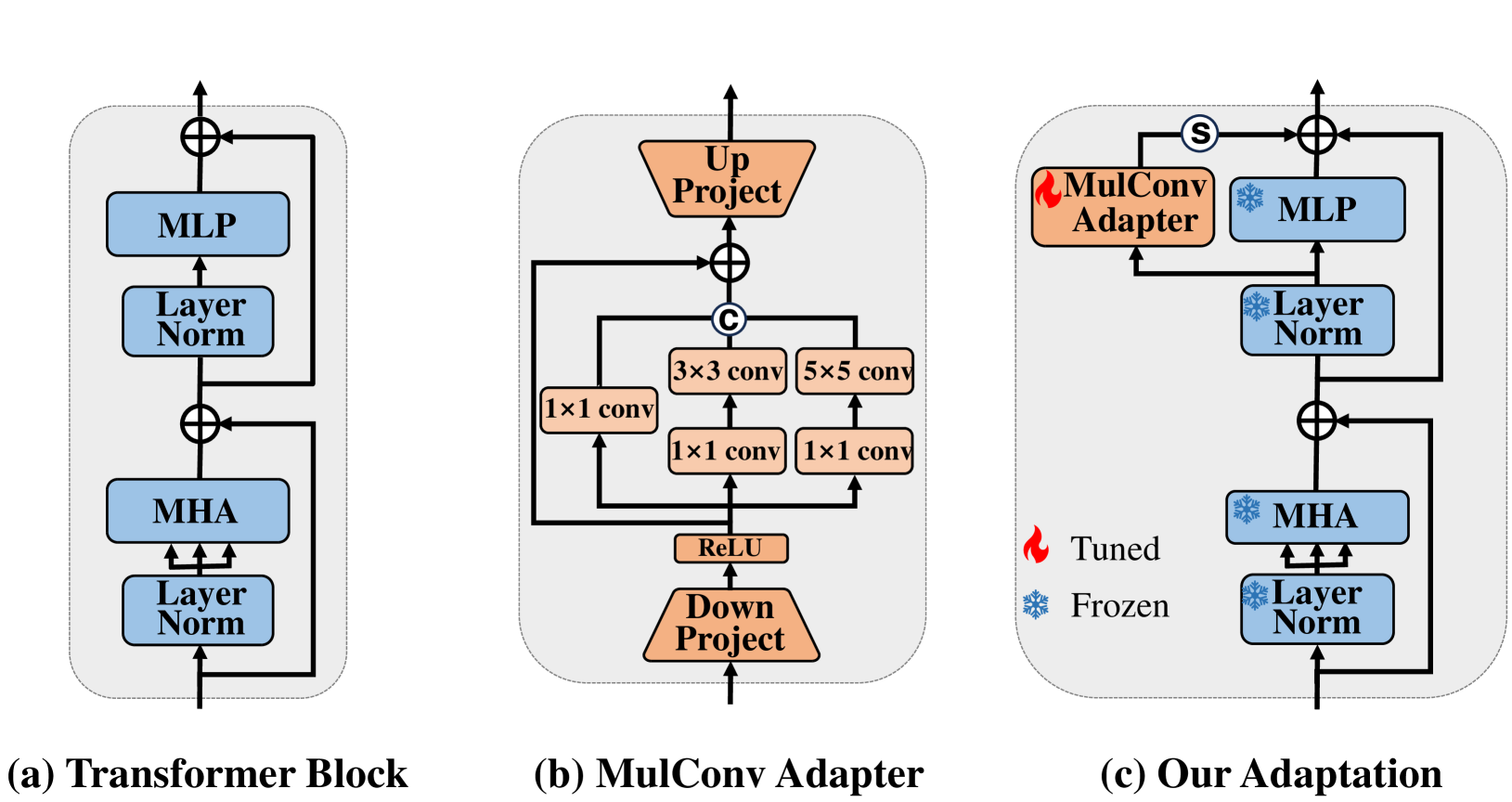

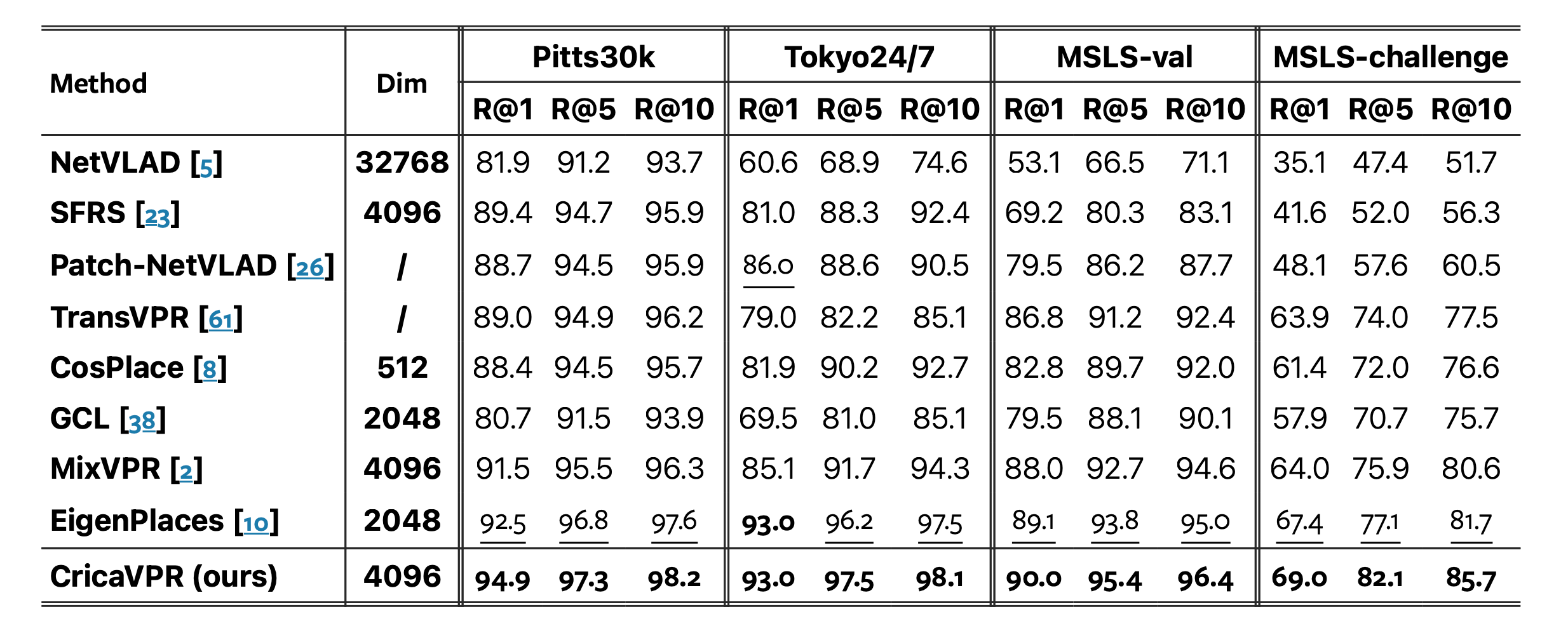

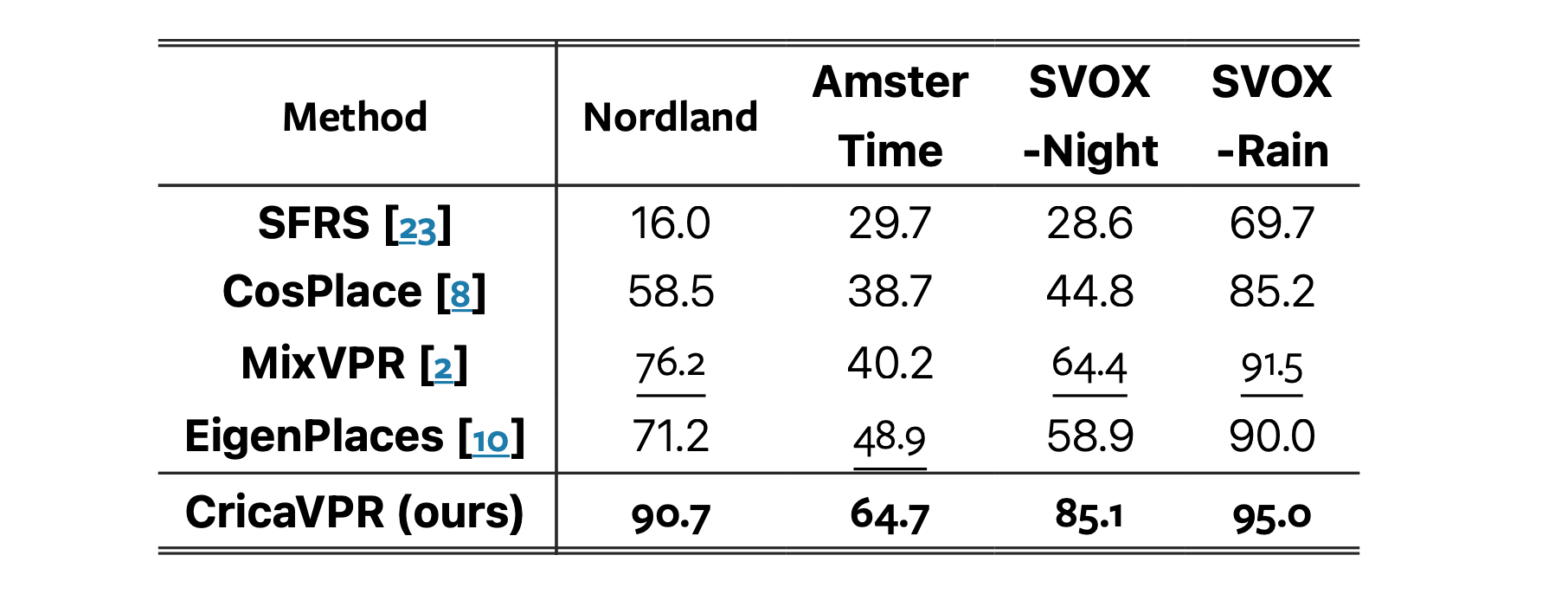

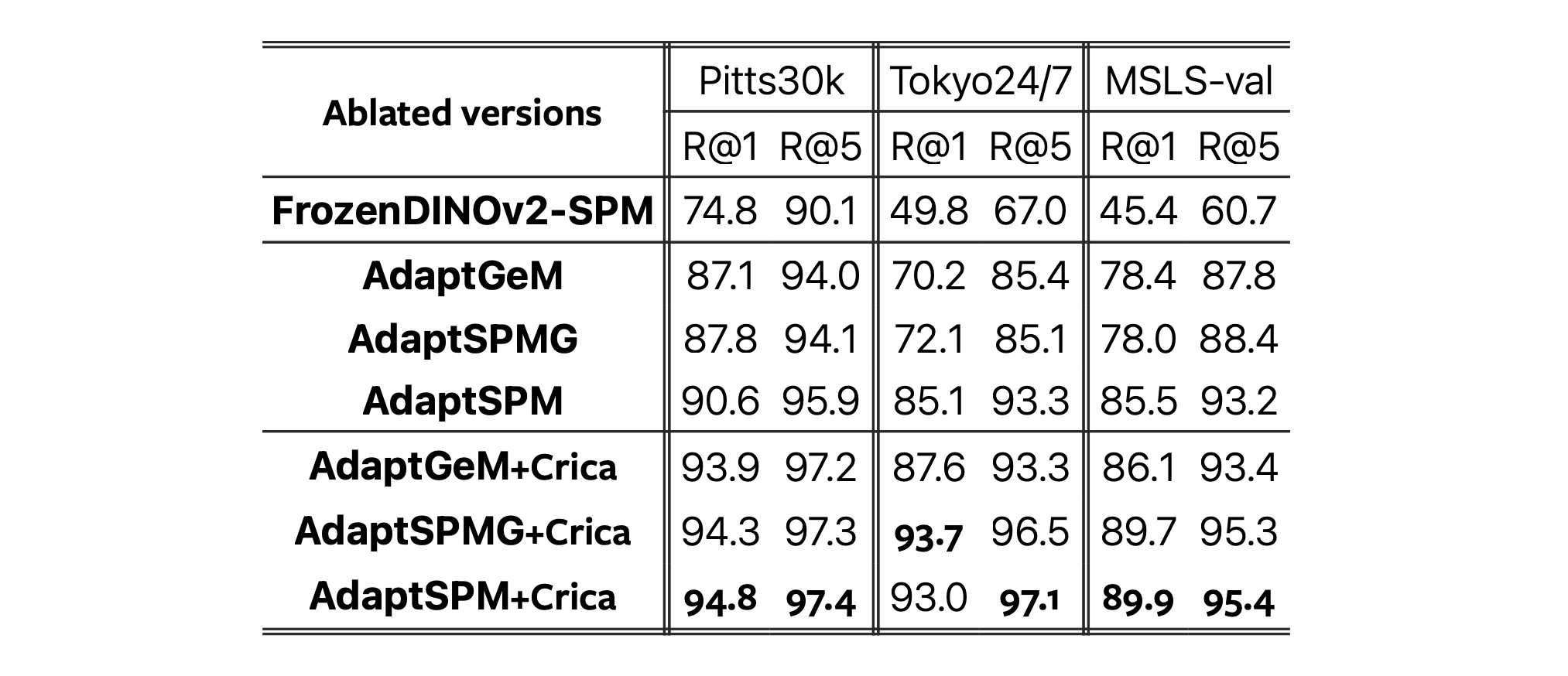

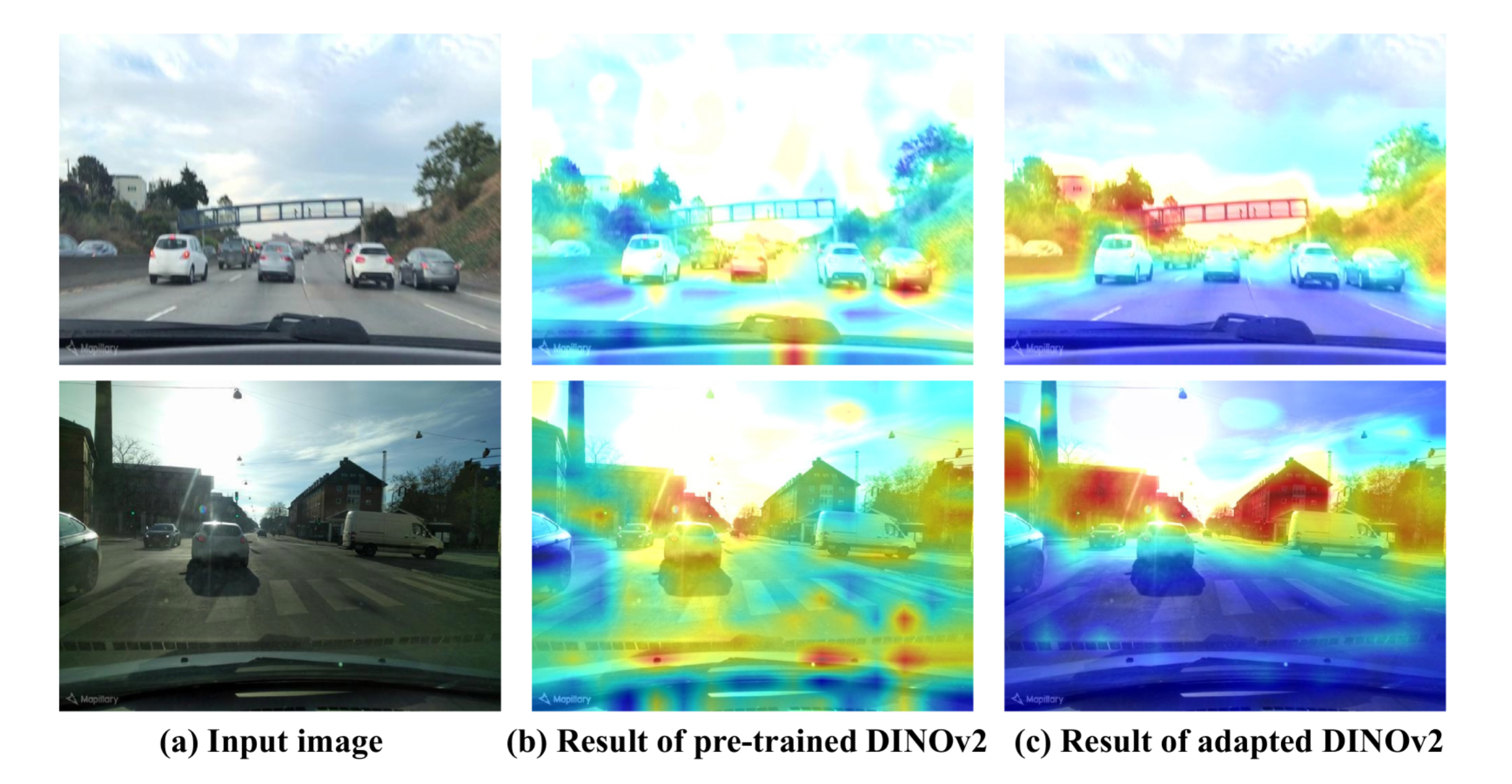

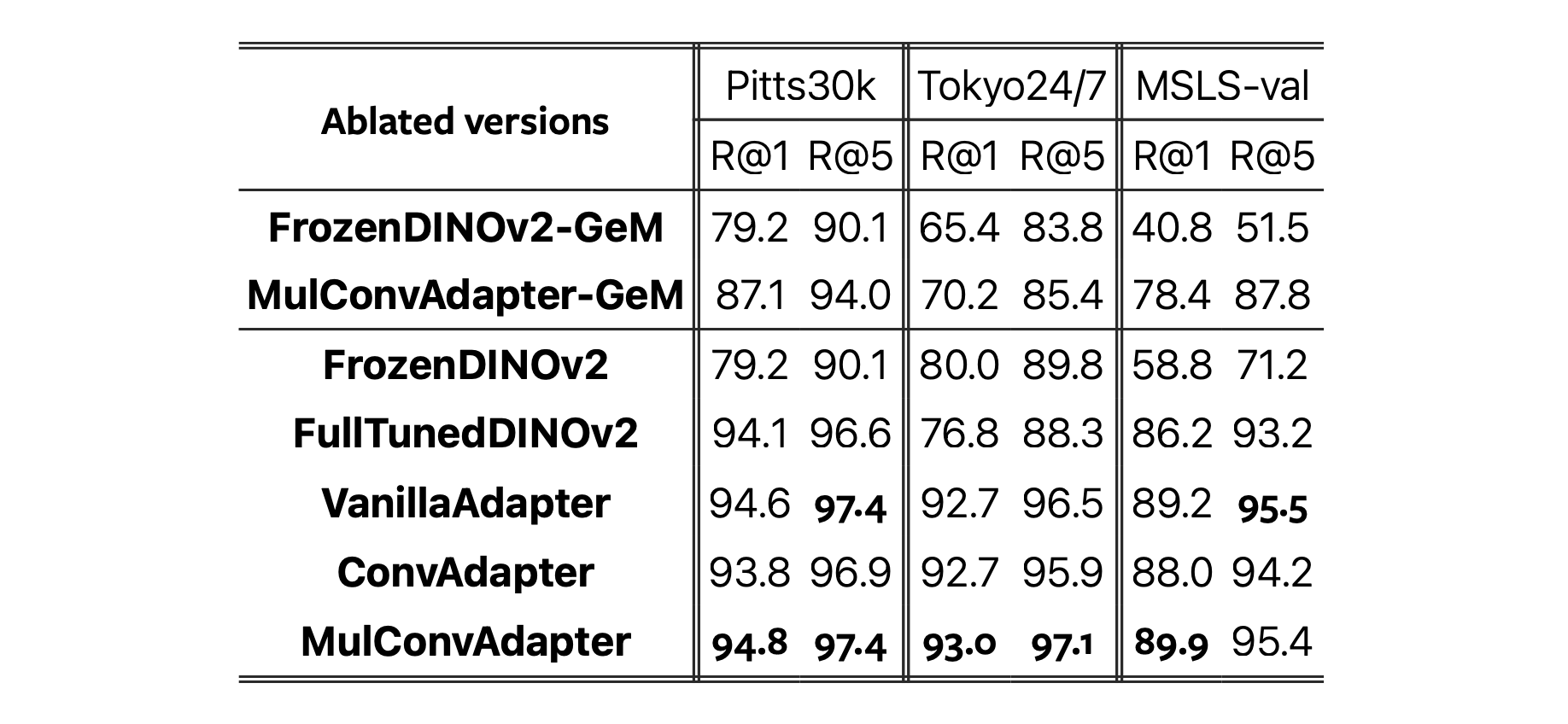

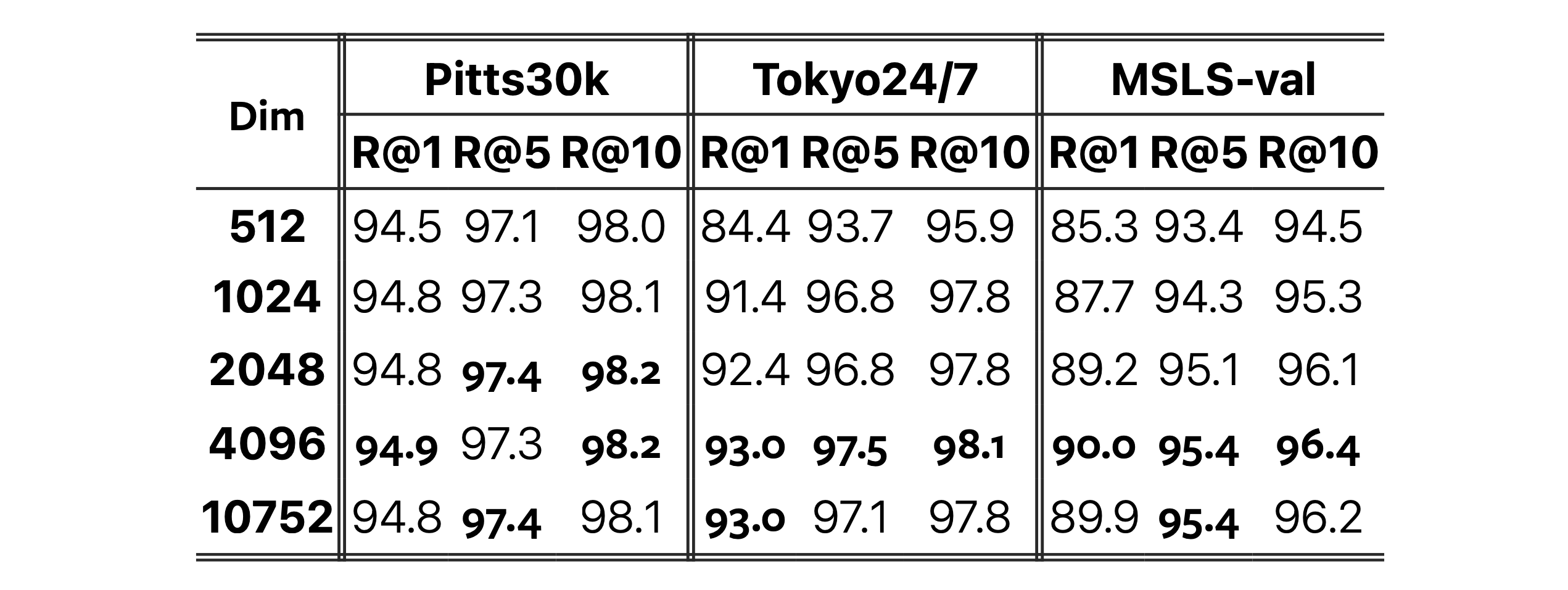

Loading... ## 论文地址 https://arxiv.org/abs/2402.19231 ## 论文摘要 本文提出了一种具有跨图像相关性意识的鲁棒全局表示方法用于视觉位置识别(VPR)任务,命名为 CricaVPR。本文方法使用自注意力机制来关联批处理中的多幅具有不同条件或视角的图像。因此,本文方法通过利用图像间的变化指导学习,以确保特征的鲁棒性。为加强这一点,本文还引入了一种多尺度卷积增强策略,它通过融合多尺度局部信息来改进预训练的视觉基础模型,使其更适合 VPR 任务,进一步提升了对图像间关系的敏感性。  ## 本文动机 ### 1、对于仅依赖全局特征方法的鲁棒性考虑 VPR 任务面临三大挑战:条件(如照明、天气、季节)变化、视角变化以及感知歧义(难以区分外观高度相似的图像)。同时应对这些问题极具挑战性,尤其是对于仅依赖全局特征的方法而言。 > 本文使用带有池模块的骨干来生成初始特征表示,然后使用配备自注意力的交叉图像编码器来计算批处理中多个图像表示之间的相关性,以获得最终特征。批量图像可以在不同条件下(例如照明)或从不同角度拍摄,甚至可以从不同地点拍摄。该过程允许每个功能用来自其他人的有用信息来增强自己,从而产生条件强健、观点强健和判别性表示。 ### 2、如何在 VPR 任务中应用预训练基础模型 VPR 任务直接应用预训练基础模型存在挑战,如忽略关键背景、受动态前景干扰,虽然微调可提升性能,但可能导致原有学习能力丧失(灾难性遗忘)。 > 本文使用可视化基础模型作为我们架构的支柱,并设计了一种多尺度卷积增强适应方法,其中冻结了预先训练的基础模型,并插入了一些可训练的轻量级适配器,以引入多尺度本地先验知识,并为VPR任务调整基础模型。 ## 本文方法 ### 跨图像相关性感知的位置表征 神经网络驱动的方法成为视觉位置识别(VPR)的主流,这些方法通常仅使用图像本身生成深度特征表示,这类特征在挑战性环境中常常缺乏鲁棒性,且无法解决感知别名问题。本文试图将一批场所图像的特征相关联,使得每个图像表示都能从其他图像表示中获取有用信息,以增强自身的鲁棒性。  具体来说,一组图像可能包括同一地点在不同视角或条件下拍摄的照片,或者是看起来相似(或不相似)的不同地点的照片,如图2所展示的那样。一方面,通过相关编码,同一地点不同视角和条件下的图像表征能够相互增强视角和条件的稳定性。另一方面,不同地点的图像表征互相促进,产生更具区分力的特征。因此,本文方法能提供高度鲁棒的全局表示,以应对视角变化、条件变化和感知别名。  ViT 骨干网络输出的一批图像的 `Patch Tokens` 被重塑为 $B \times W \times H \times D$ 维的特征图,然后使用空间金字塔来生成初始特征表示。特征图在三个层次上分割($1 \times 1$、$2 \times 2$ 和 $3 \times 3$),并使用 GeM 池化处理被划分区域内的局部(patch)特征,并为每张图像获取共 14 个区域特征。由于第一层是全局聚合,我们直接使用类别令牌替换这一层的 GeM 特征以获得更好的性能。 接下来,跨图像编码器是批量建模不同图像特征之间相关性的核心组件,我们将批图像中所有图像的第 $i$ 个区域特征视为一个嵌入向量序列 $f_i$ ,即: $$ f_i = \{f_{i}^1, f_{i}^2, \ldots, f_{i}^B\} \qquad i \in \{1, 2, \ldots, 14\} $$ 并将这 14 个嵌入向量序列输入跨图像编码器,以建模一批图像的第 $i$ 个区域特征之间的相关性。跨图像编码器不是直接使用自注意力层,而是采用两个 Transformer 编码器层构建,这些层还包括后续的 MLP 层和跳跃连接,以相关联一批中的图像表示,实现稳定训练和更佳性能。每个图像的14个输出区域特征被顺序串联(展平)作为图像的最终全局表示,最后的检索过程与常见的基于全局检索的方法相同,就是使用单个图像的全局特征进行检索。 ### 多尺度卷积增强适配器 本文采用了经过蒸馏的 DINOv2 作为骨干网络,该网络基于 ViT-B/14 通过自监督策略在大规模数据集上训练,能够提供强大的视觉特征,并在常见任务上无需任何微调实现令人瞩目的性能。基于适配器(Adapter)的参数高效迁移学习为下游任务有效地适配基础模型提供了方法,通过冻结预训练模型并仅对新增的轻量级适配器进行微调。  受 GoogLeNet 中 Inception 模块的启发,作者设计了如下多尺度卷积适配器(MulConv-Adapter),本文方法在 ReLU 激活层和上采样层之间引入了 MulConv 模块,该模块结合三种不同尺度($1 \times 1$ 、 $ 3 \times 3 $ 和 $5 \times 5$)的并行卷积路径,并在 $3 \times 3$ 和 $5 \times 5$ 卷积之前使用了 $1 \times 1$ 卷积来减少通道维度,三条卷积路径的输出被串联起来构成 MulConv 模块的输出,最后通过跳跃连接的残差结构实现特征增强。 该设计以及适配器的瓶颈结构确保了多尺度卷积适配器依然保持轻量级,多尺度卷积适配器被并行地集成进 ViT 骨干的每个 Transformer 块中,实现了多尺度卷积的增强适配。这不仅为模型注入了恰当的多尺度局部先验知识,还显著提升了视觉位置识别(VPR)的性能。因此,每个适配后的变换器块的计算可以表示为: $$ z_l' = MHA(LN(z_{l-1})) + z_{l-1} $$ $$ z_l = MLP(LN(z_l')) + s \cdot Adapter(LN(z_l')) + z_l' $$ ## 实验结果 ### 1、对比实验   这四个具有挑战性的示例显示了严重的视角变化和条件变化。本文提出的 CricaVPR 成功地得到了正确的结果,而其他方法返回了错误的图像。在每个示例中,由于感知歧义,有些方法返回了来自不同地方的相似图像(即错误的)。在第二个示例中,查询图像是在夜间拍摄的,导致所有其他方法都返回了不同地方的夜间图像(即错误的),而本文方法返回了同一地点白天拍摄的图像(即正确的)。  ### 2、消融实验 #### 跨图像相关性感知上的消融  **“+Crica”** 代表增加了本文的跨图像相关性感知以获取最终的全局特征,**“SPM”** 代表本文同时使用类令牌和 GeM 的空间金字塔模型表示,而 **“SPMG”** 则是仅基于 GeM 的空间金字塔模型。除了直接使用未调整的骨干网络(作为基线)的 DINOv2-GeM 和 DINOv2-SPM 外,所有其他版本都使用本文方法进行了微调。 #### 多尺度卷积增强适配器上的消融  预训练的 DINOv2 关注的区域与位置识别无关,然而经过适配器微调的 DINOv2 专注于对 VPR 具有区分性的区域。随时间相对不变的建筑物获得最高的关注,预计短期内不会改变的植被获得适度的关注,非区分性元素如天空和地面以及动态的车辆则被忽略。  除了带有 **“-GeM”** 后缀表示使用 GeM 特征的版本外,其他所有版本都采用了本文提出的带有跨图像感知的空间金字塔表示来生成全局特征。FrozenDINOv2 和 FullTunedDINOv2 分别代表使用冻结和完全微调的 DINOv2 作为骨干网络。VanillaAdapter、ConvAdapter 和 MulConvAdapter 分别代表使用基础适配器、$3 \times 3$ 卷积适配器和本文提出的多尺度卷积适配器来微调 DINOv2 作为骨干网络。 #### 描述符维度上的消融  直觉上,高维描述符能够提供更多信息,因此有潜力实现更好的性能,然而,去除冗余或噪声信息也常会带来性能提升。本文分析了描述符维度对性能的影响,结果如上图所示,由于某些数据集中剧烈的条件变化和感知别名问题,需要更高维的描述符来提供足够的信息以区分地点,因此随着描述符维度下降,模型在数据集上性能会发生明显下降。 Last modification:August 4, 2024 © Allow specification reprint Support Appreciate the author AliPayWeChat Like 如果觉得我的文章对你有用,请随意赞赏